format_list_bulleted Contenido

Cómo la IA médica puede discriminar sin querer: causas de los sesgos, ejemplos reales, riesgos para pacientes y hospitales, y medidas para evitarlos.

La inteligencia artificial está transformando la atención médica a una velocidad vertiginosa. Promete diagnosticar enfermedades como un experto, personalizar tratamientos y hacer que la sanidad sea más eficiente y accesible. Pero, ¿qué pasa si esta tecnología revolucionaria está perpetuando las mismas desigualdades que tanto nos esforzamos por eliminar? Los sistemas de IA en atención médica están demostrando tener sesgos profundos que pueden exacerbar las disparidades de salud existentes, especialmente para grupos minoritarios y vulnerables.

El problema no es nuevo. La medicina ha luchado contra sesgos y desigualdades durante décadas, pero la IA introduce una dimensión completamente nueva a este desafío. A diferencia del sesgo humano, que puede ser identificado y corregido, el sesgo algorítmico está incrustado en el código y en los datos, operando a una escala y velocidad que supera nuestra capacidad de supervisión humana. ¿Estamos construyendo sistemas que, en lugar de nivelar el campo de juego, están creando una nueva forma de discriminación médica?

warning El Problema del "Sesgo Dentro, Sesgo Fuera"

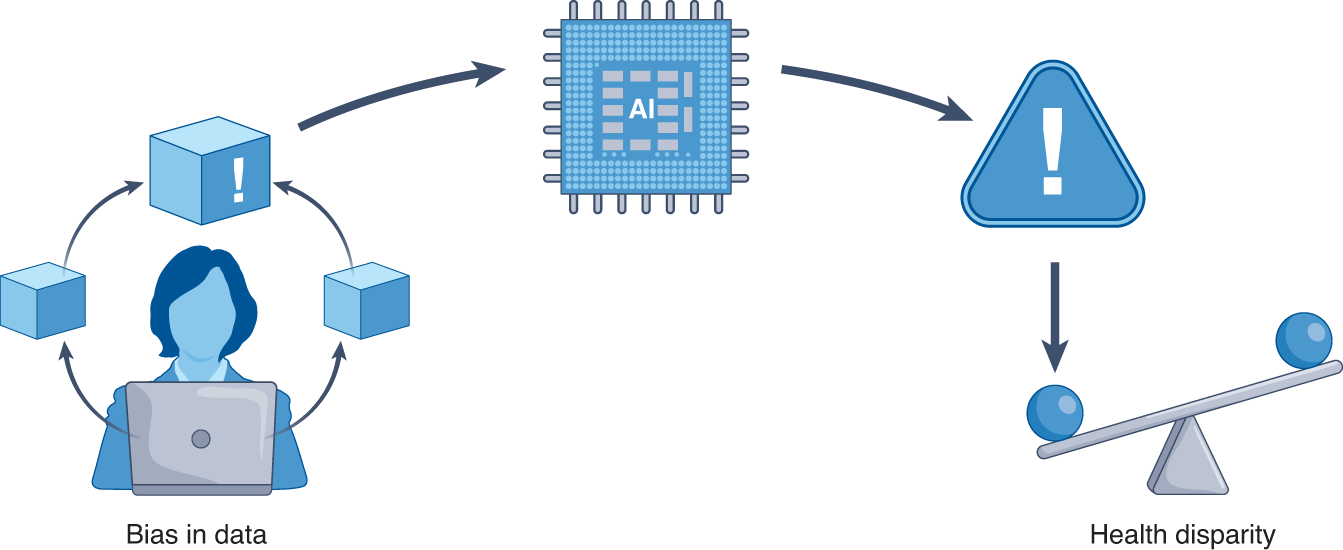

En el mundo de la IA, existe un principio fundamental conocido como "sesgo dentro, sesgo fuera", una variación del clásico "basura dentro, basura fuera". Esto significa que los algoritmos de IA aprenden de los datos con los que son entrenados. Si esos datos contienen sesgos históricos o representaciones desequilibradas de ciertos grupos poblacionales, el sistema inevitablemente perpetuará y amplificará estas desigualdades. En el contexto médico, esto no es simplemente un problema técnico, sino una cuestión de vida o muerte para muchos pacientes.

Este artículo explora en profundidad cómo los sesgos se manifiestan en los sistemas de IA para la atención médica, examinando ejemplos concretos que ya están afectando a pacientes, analizando las causas raíces de este problema y presentando estrategias para desarrollar sistemas más equitativos. Porque si la IA va a cumplir su promesa de revolucionar la sanidad, debe hacerlo para todos, no solo para unos pocos.

category Tipos de Sesgos en Sistemas Médicos de IA

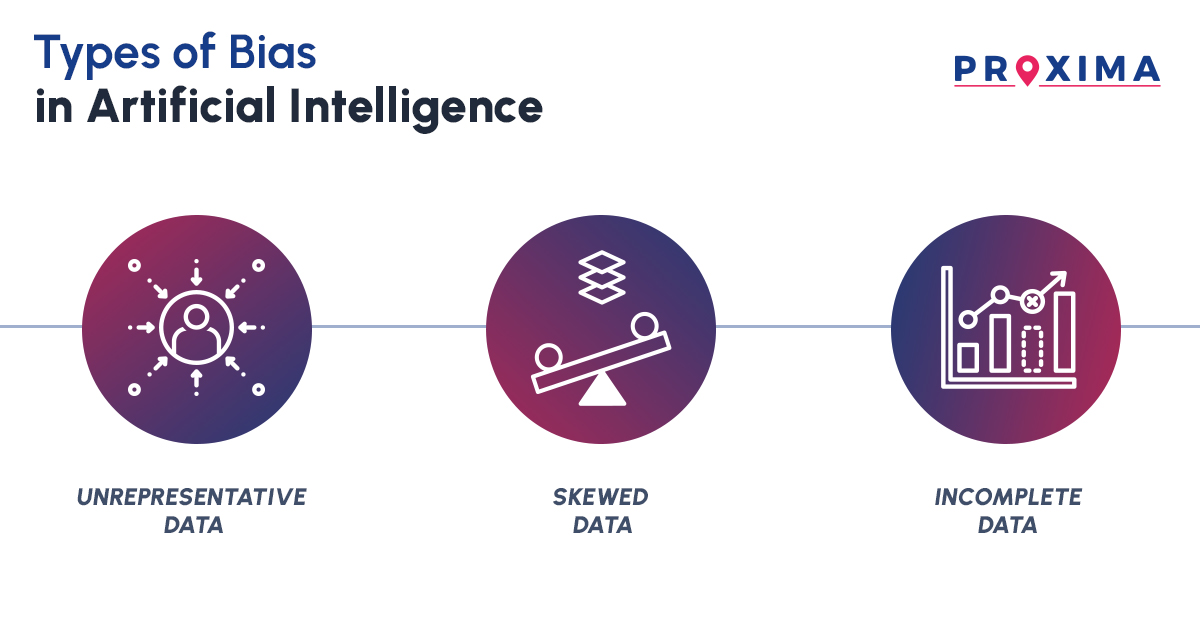

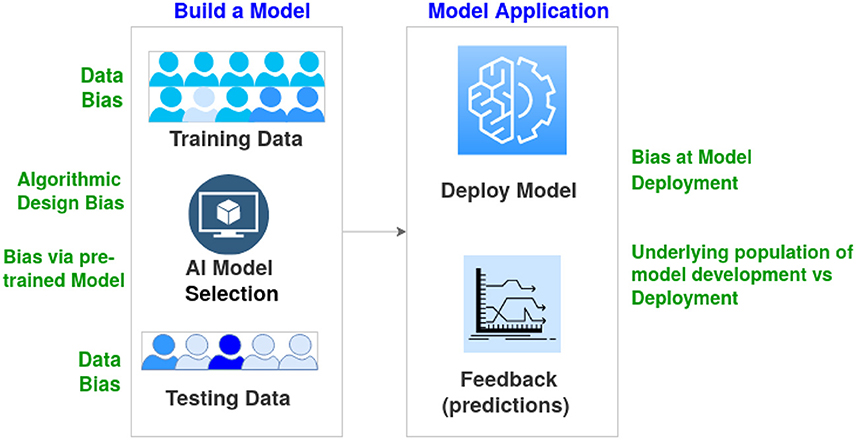

Los sesgos en los sistemas de IA médica no son un fenómeno único, sino que se manifiestan de múltiples formas a lo largo de todo el ciclo de vida del algoritmo. Comprender estos diferentes tipos de sesgos es el primer paso para desarrollar estrategias efectivas de mitigación. Los sesgos pueden originarse en los datos, en el diseño del algoritmo, o en su implementación clínica.

psychology Sesgos de Origen Humano

Los sesgos humanos son la fuente dominante de problemas en los sistemas de IA médica. Aunque rara vez se introducen deliberadamente, reflejan percepciones, suposiciones o preferencias históricas que pueden manifestarse en todas las etapas del desarrollo del algoritmo.

Sesgo implícito

Ocurre cuando actitudes o estereotipos subconscientes sobre características de una persona o grupo (como raza, género, edad o estatus socioeconómico) se incrustan en las decisiones médicas que luego se utilizan para entrenar algoritmos. Por ejemplo, si los médicos históricamente han subestimado los síntomas cardíacos en mujeres, un algoritmo entrenado con estos datos heredará este sesgo.

Sesgo sistémico

Representa normas, prácticas o políticas institucionales más amplias que pueden llevar a inequidades sociales. A diferencia del sesgo implícito, el sesgo sistémico es más estructural y a menudo requiere cambios en la legislación o políticas institucionales para ser abordado. Un ejemplo sería cómo el acceso desigual a la atención médica en diferentes comunidades crea datos que reflejan estas disparidades.

code Sesgos en el Desarrollo de Algoritmos

Más allá de los sesgos humanos, el propio proceso de desarrollo de algoritmos puede introducir o amplificar sesgos de varias maneras:

Sesgo de representación

Ocurre cuando los datos de entrenamiento no representan adecuadamente la diversidad de la población. Por ejemplo, los algoritmos para detectar melanoma suelen entrenarse principalmente con imágenes de piel clara, lo que resulta en una precisión significativamente menor para pacientes con piel oscura.

Sesgo de medición

Sucede cuando los instrumentos o métodos de recolección de datos son menos precisos para ciertos grupos. Un ejemplo preocupante es el oxímetro de pulso, que sobrestima sistemáticamente los niveles de oxígeno en pacientes con piel más oscura, llevando a diagnósticos incorrectos.

cases Ejemplos Concretos de Sesgos en la Práctica

La teoría es importante, pero nada ilustra mejor el problema de los sesgos en la IA médica que ejemplos reales que ya están afectando a pacientes en todo el mundo. Estos casos no son hipotéticos; representan desafíos inmediatos que requieren atención urgente.

medical_services Diagnóstico de Melanoma en Piel Oscura

Las redes neuronales convolucionales que clasifican lesiones cutáneas han demostrado una precisión impresionante, a menudo igualando o superando a los dermatólogos. Sin embargo, la mayoría de estos sistemas se entrenan con conjuntos de datos donde solo el 5-10% de las imágenes corresponden a pacientes de piel oscura. El resultado es alarmante: cuando se prueban con imágenes de pacientes negros, estos algoritmos tienen aproximadamente la mitad de precisión diagnóstica. Esto es particularmente preocupante porque los pacientes negros tienen la tasa de mortalidad más alta por melanoma, con una supervivencia a 5 años del 70% frente al 94% de los pacientes blancos.

monitor_heart Algoritmos de Gestión de Población

Un estudio publicado en Science reveló que un algoritmo ampliamente utilizado para gestionar la salud de poblaciones utilizaba los costos de atención médica como un indicador de las necesidades de salud. El problema: históricamente, se ha gastado menos dinero en pacientes negros que en pacientes blancos con las mismas condiciones. Como resultado, el algoritmo concluyó falsamente que los pacientes negros eran más saludables, dándoles menor prioridad para programas de manejo de enfermedades crónicas como diabetes y enfermedad renal, a pesar de tener índices de gravedad más altos.

favorite Diagnóstico de Enfermedades Cardíacas en Mujeres

Los ataques cardíacos son diagnosticados erróneamente con alarming frecuencia en mujeres, en parte porque los síntomas pueden diferir de los típicamente observados en hombres. A pesar de esto, muchos modelos de IA para predecir enfermedades cardiovasculares se entrenan predominantemente con datos de pacientes masculinos. Dado que las enfermedades cardíacas se manifiestan de manera diferente en hombres y mujeres, estos algoritmos pueden no ser tan precisos para el diagnóstico femenino, perpetuando una disparidad de salud ya existente.

trending_down Impacto en las Disparidades de Salud

Los sesgos en los sistemas de IA médica no son simplemente problemas técnicos abstractos; tienen consecuencias reales y medibles en la salud de las personas. Estos algoritmos están ampliando las brechas existentes en lugar de reducirlas, creando un ciclo vicioso donde las disparidades de salud se perpetúan y amplifican a través de la tecnología.

loop El Ciclo de Reforzamiento de Desigualdades

Cuando un algoritmo de IA médica se entrena con datos históricos que contienen disparidades, inevitablemente aprende y perpetúa estas mismas desigualdades. Por ejemplo:

Diagnósticos tardíos

Los sistemas que son menos precisos para ciertos grupos pueden llevar a diagnósticos tardíos, cuando las condiciones son más difíciles de tratar y tienen peores pronósticos. Esto crea datos que muestran peores resultados para esos grupos, reforzando el sesgo original en futuros algoritmos.

Acceso desigual a intervenciones

Los algoritmos que priorizan pacientes para tratamientos o programas de manejo de enfermedades pueden asignar sistemáticamente menor prioridad a grupos minoritarios, incluso cuando tienen necesidades médicas similares o mayores. Esto resulta en peores resultados de salud que luego se reflejan en los datos, perpetuando el ciclo.

coronavirus El Caso de la COVID-19

La pandemia de COVID-19 puso de manifiesto cómo los sistemas de IA pueden amplificar las desigualdades existentes. Bajo la presión por desarrollar soluciones rápidamente, muchos algoritmos se implementaron sin una validación adecuada en poblaciones diversas. El resultado: sistemas que funcionaban razonablemente bien para grupos mayoritarios, pero fallaban estrepitosamente para comunidades minoritarias que ya estaban desproporcionadamente afectadas por la pandemia. Esto no es un problema teórico; representa vidas perdidas que podrían haberse salvado con sistemas más equitativos.

search Causas Raíces del Problema

Para abordar efectivamente los sesgos en los sistemas de IA médica, es crucial entender sus causas fundamentales. Estas no son simples fallas técnicas, sino problemas complejos que involucran factores técnicos, sociales, económicos y regulatorios.

dataset Fragmentación de Datos Médicos

Los datos médicos están notoriamente fragmentados en silos, aislados en diferentes instituciones, sistemas y formatos. Esta fragmentación dificulta enormemente la creación de conjuntos de datos diversos y representativos. Como señaló un veterano frustrado: "¿Cómo es que podemos ver un coche específico en un convoy en movimiento al otro lado del mundo, pero no podemos ver mi TC del hospital de la calle?". La falta de interoperabilidad entre sistemas de registros médicos sigue siendo una barrera técnica formidable.

lock Preocupaciones de Privacidad y Regulación

La privacidad de los datos médicos está protegida por leyes estrictas, y con buena razón. Sin embargo, estas regulaciones, aunque necesarias, a menudo dificultan el intercambio de datos que sería beneficioso para entrenar algoritmos más equitativos. Además, el escepticismo público sobre el uso de datos personales, alimentado por años de abusos por parte de empresas tecnológicas, ha creado un ambiente donde cualquier intento de agregar datos médicos, incluso para fines benéficos, es recibido con desconfianza.

attach_money

Los incentivos económicos en el sistema de salud a menudo trabajan en contra de la equidad. Un estudio encontró que los hospitales que comparten datos son más propensos a perder pacientes ante competidores locales. Esto crea un entorno donde la colaboración necesaria para desarrollar conjuntos de datos diversos se ve obstaculizada por consideraciones de mercado. Además, los grupos minoritarios y desfavorecidos, que a menudo tienen menos recursos y poder político, son los que menos se benefician de los avances tecnológicos en salud.

lightbulb Estrategias para Mitigar los Sesgos

Afortunadamente, el problema de los sesgos en la IA médica no es insuperable. Investigadores, clínicos y desarrolladores están explorando múltiples enfoques para crear sistemas más equitativos. Estas estrategias abarcan desde mejoras técnicas hasta cambios fundamentales en cómo recolectamos y compartimos datos médicos.

diversity_3 Enfoques de Ciencia Abierta y Participativa

La ciencia abierta ofrece herramientas poderosas para abordar los sesgos en la IA médica. Esto incluye:

Desarrollo centrado en el participante

Involucrar a comunidades diversas en el desarrollo de algoritmos desde el principio, asegurando que sus necesidades y perspectivas se reflejen en el producto final. Esto va más allá de simplemente consultar a grupos minoritarios; se trata de darles un rol activo en el diseño e implementación.

Intercambio responsable de datos

Crear marcos que permitan compartir datos médicos de manera segura y ética, preservando la privacidad mientras se fomenta la diversidad. Esto incluye el desarrollo de estándares de datos inclusivos que apoyen la interoperabilidad entre sistemas.

balance Métricas de Equidad y Evaluación Rigurosa

Definir y medir la equidad en los sistemas de IA médica es complejo pero esencial. Esto incluye:

Métricas de justicia

Implementar métricas como paridad demográfica, probabilidades igualadas, igualdad de oportunidades y justicia contrafactual. Estas métricas deben aplicarse con una comprensión profunda del contexto médico y las experiencias vividas de diversas poblaciones de pacientes.

Validación externa

Un estudio encontró que solo el 15.5% de los modelos de IA basados en neuroimagen para diagnóstico psiquiátrico incluían validación externa, mientras que el 97.5% incluían solo sujetos de regiones de altos ingresos. Es crucial probar los algoritmos en poblaciones diversas antes de su implementación clínica.

settings_suggest Innovaciones Técnicas

Los investigadores están desarrollando nuevas técnicas para abordar los sesgos directamente en los algoritmos:

Síntesis de datos subrepresentados

Compartir algoritmos de IA que pueden sintetizar datos para grupos subrepresentados, ayudando a equilibrar los conjuntos de entrenamiento sin comprometer la privacidad de los pacientes.

Algoritmos sensibles al contexto

Desarrollar sistemas que reconozcan y adapten sus predicciones según el contexto demográfico y social del paciente, en lugar de aplicar un enfoque único para todos.

play_circle El Sesgo Oculto en la IA Sanitaria

Para comprender mejor cómo los sesgos en los sistemas de IA están afectando la atención médica, te invitamos a ver este video que explora una de las preguntas más urgentes en salud digital: ¿podemos confiar realmente en la IA en la atención médica?

summarize Conclusión: Hacia una IA Médica más Equitativa

La inteligencia artificial tiene el potencial de transformar la atención médica de maneras que apenas estamos comenzando a imaginar. Pero este potencial solo se realizará plenamente si abordamos los sesgos sistémicos que amenazan con perpetuar y amplificar las desigualdades existentes. El desafío es formidable, pero no insuperable.

handshake Un Esfuerzo Colectivo

Abordar los sesgos en la IA médica requiere un enfoque multidisciplinario que involucre a:

Investigadores y desarrolladores

Que prioricen la equidad desde el diseño y desarrollen técnicas para identificar y mitigar sesgos.

Profesionales de la salud

Que aporten su experiencia clínica y aboguen por sistemas que sirvan a todos los pacientes por igual.

Pacientes y comunidades

Que participen activamente en el desarrollo e implementación de sistemas que afectarán su salud.

Responsables políticos

Que creen marcos regulatorios que fomenten la innovación equitativa y protejan a los grupos vulnerables.

visibility Transparencia y Responsabilidad

Para que la IA médica sea verdaderamente equitativa, necesitamos sistemas transparentes que permitan auditar y entender cómo se toman las decisiones. Esto no solo es una cuestión técnica, sino ética. Los pacientes tienen derecho a saber por qué un algoritmo recomienda un tratamiento particular, y los médicos deben poder cuestionar y contextualizar estas recomendaciones.

Como hemos aprendido de lecciones pasadas en la historia de la medicina, como la subrepresentación de mujeres y minoritarios en los ensayos clínicos, abordar las desigualdades requiere un esfuerzo concertado y sostenido. La historia del oxímetro de pulso, que durante décadas funcionó peor para pacientes con piel oscura, nos recuerda que incluso las tecnologías más establecidas pueden tener sesgos profundamente arraigados.

"No podemos seguir adelante ciegamente, construyendo e implementando herramientas con los datos que suceden estar disponibles, deslumbrados por un barniz digital y promesas de progreso, y luego lamentar las 'consecuencias imprevistas'. Las consecuencias son previsibles. Pero no tienen que ser inevitables."

La IA médica está en una encrucijada. Por un camino, está la tentación de priorizar la velocidad y la eficiencia sobre la equidad, perpetuando las mismas desigualdades que han plagado la medicina durante generaciones. Por el otro, está la oportunidad de construir sistemas que no solo sean más inteligentes, sino también más justos, que sirvan a todos los pacientes sin importar su raza, género, edad o estatus socioeconómico.

La elección es nuestra. La tecnología es solo una herramienta; es nuestro uso de ella lo que determinará si amplifica o mitiga las desigualdades en salud. Si queremos que la IA cumpla su promesa de revolucionar la medicina para mejor, debe hacerlo para todos, no solo para unos pocos.