Científicos de Caltech logran un hito sin precedentes: entrelazar el movimiento y el estado interno de átomos individuales, abriendo nuevas fronteras para la computación y la simulación cuántica.

Introducción: Del Experimento Mental de Maxwell a la Realidad Cuántica en el Laboratorio

El universo, en sus escalas más fundamentales, es un ballet de partículas en constante movimiento. Pero ese movimiento, ese "vaivén térmico" aleatorio y caótico, es la esencia del desorden que la segunda ley de la termodinámica describe tan implacablemente. Esta ley fundamental postula que la entropía, la medida del desorden en un sistema aislado, siempre tiende a aumentar. Sin embargo, hace más de 150 años, el genio escocés James Clerk Maxwell planteó un experimento mental que desafiaba audazmente esta noción: la idea de un "demonio de Maxwell".

Este ser imaginario, dotado de la capacidad de observar y manipular partículas individuales en una caja llena de gas, podría teóricamente clasificar moléculas según su velocidad, permitiendo que las rápidas pasaran a un compartimento y las lentas a otro. El resultado aparente sería una disminución de la entropía sin aporte de trabajo externo, una violación flagrante de la segunda ley. Aunque el demonio de Maxwell nunca existió, su concepto ha sido un fértil campo de pruebas para la física, impulsando el estudio de los límites de la termodinámica, la información y el control a escala atómica.

Hoy, en los laboratorios de física cuántica del siglo XXI, el espíritu de aquel demonio parece haber cobrado una nueva vida. Un grupo de investigadores del prestigioso Instituto Tecnológico de California (Caltech), liderados por el físico Manuel Endres, ha logrado algo que recuerda asombrosamente a la hazaña conceptual de Maxwell: han desarrollado una técnica que les permite controlar el movimiento térmico de átomos individuales con una precisión sin precedentes. Lo que normalmente se considera "ruido" térmico, un obstáculo para la coherencia cuántica, ha sido transformado en información cuántica útil, abriendo un camino prometedor hacia una nueva era en la computación y simulación cuántica.

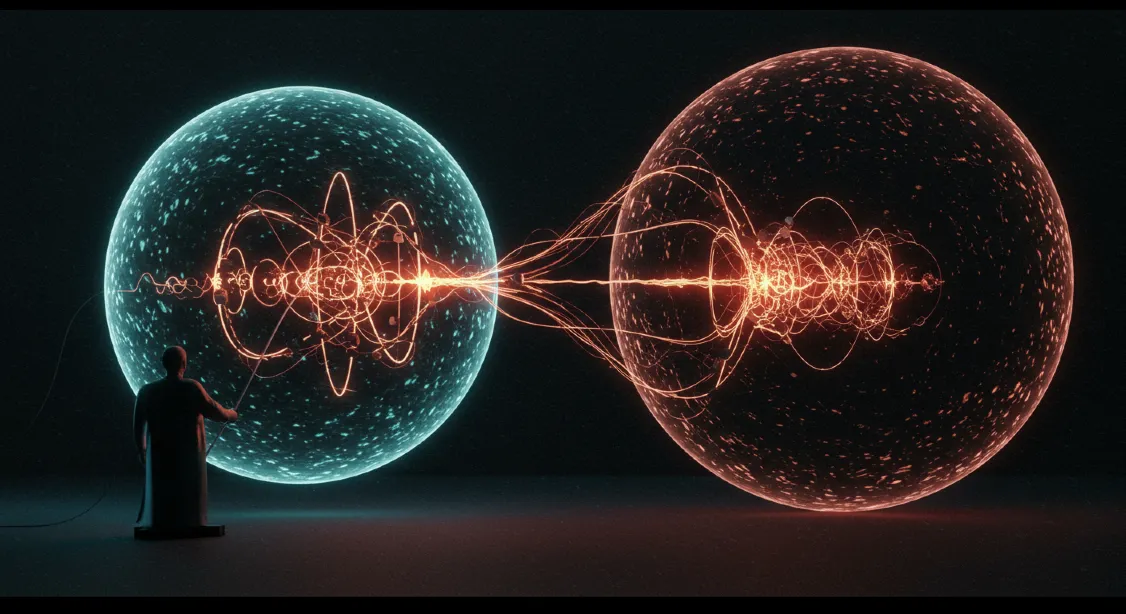

Pero el hito no se detiene ahí. Este equipo ha logrado por primera vez algo aún más extraordinario: entrelazar no solo los estados internos (energía o espín) de partículas, sino también su movimiento físico. Este doble entrelazamiento, conocido como hiperentrelazamiento, había sido observado anteriormente solo en fotones (partículas sin masa). El éxito en lograr el hiperentrelazamiento en partículas masivas, como átomos neutros, representa un avance tecnológico y conceptual sin precedentes en el campo de la física cuántica, con profundas implicaciones para la forma en que codificamos y procesamos información en futuros ordenadores cuánticos.

Este artículo profundiza en este asombroso experimento y sus implicaciones. Exploraremos el concepto del demonio de Maxwell y su relevancia histórica, desglosaremos cómo el equipo de Caltech ha logrado este control sin precedentes sobre el movimiento atómico individual, explicaremos qué es exactamente el hiperentrelazamiento cuántico y por qué su logro en átomos masivos es tan significativo. Analizaremos cómo esta nueva técnica puede ser una herramienta poderosa para la computación y simulación cuántica, y discutiremos las múltiples aplicaciones potenciales que esta tecnología podría desbloquear, desde relojes atómicos ultraprecisos hasta nuevas formas de memoria y comunicación cuántica. En el corazón de este avance yace una idea fundamental: la capacidad de convertir el desorden en una herramienta, transformando el ruido térmico en un recurso valioso para la información cuántica.

El experimento de Caltech no es un mero "truco de laboratorio"; es un hito que empuja los límites de lo que creíamos posible en el control de la materia a escala cuántica, acercándonos un paso más a la construcción de computadoras cuánticas estables y potentes, y demostrando que las ideas más audaces de la física teórica a menudo encuentran su eco, sorprendente, en la realidad experimental.

El Demonio de Maxwell: Un Experimento Mental que Desafió la Termodinámica

Para apreciar la magnitud del logro del experimento de Caltech, es fundamental comprender el concepto original del Demonio de Maxwell y su impacto en la física. Este experimento mental, propuesto por James Clerk Maxwell en 1867, no buscaba describir un ser real, sino explorar las implicaciones de la segunda ley de la termodinámica, una de las leyes más robustas y universales de la naturaleza.

La Segunda Ley de la Termodinámica y la Entropía:

La segunda ley de la termodinámica establece que en un sistema aislado, la entropía (la medida del desorden o la aleatoriedad) siempre tiende a aumentar con el tiempo. Los procesos naturales tienden a moverse hacia estados de mayor desorden. Por ejemplo, una taza de café caliente se enfría hasta la temperatura ambiente, y el humo se dispersa en una habitación, nunca al revés, a menos que se aplique energía externa para revertir el proceso. Esta ley es el fundamento de la "flecha del tiempo" en el universo.

El Experimento Mental del Demonio:

Maxwell imaginó una criatura minúscula, un "demonio", vigilando una pequeña puerta entre dos compartimentos de una caja llena de gas a la misma temperatura. Las partículas de gas se mueven aleatoriamente con diferentes velocidades. El demonio, con una capacidad de observación y manipulación perfecta, podría:

-

Observar la Velocidad de las Partículas: Identificar qué partículas se mueven rápido y cuáles lento.

-

Abrir y Cerrar una Puerta sin Esfuerzo: Permitir que las partículas rápidas pasen a un compartimento y las lentas al otro.

Al hacerlo, el demonio podría crear una separación: un compartimento con partículas más rápidas (calientes) y otro con partículas más lentas (frías), a partir de un estado inicial uniforme, y aparentemente sin gastar energía. Esto, hipotéticamente, disminuiría la entropía del sistema sin un aporte de trabajo, violando la segunda ley de la termodinámica. La paradoja residía en cómo algo tan simple podía violar una ley tan fundamental.

La Resolución de la Paradoja: Información y Energía:

La paradoja del demonio de Maxwell ha sido resuelta a lo largo del tiempo, principalmente a través de la comprensión de la relación entre información y energía. En los años 60, el físico Rolf Landauer demostró que el acto de borrar información inevitablemente disipa energía en forma de calor. El demonio, para "recordar" qué partículas son rápidas o lentas y así clasificarlas, debe almacenar y luego borrar esa información. El coste energético de procesar y borrar esa información es, precisamente, lo que salva la segunda ley de la termodinámica. En otras palabras, el demonio sí que gasta energía, pero no en el movimiento de la puerta, sino en el procesamiento de la información. El ruido se transforma en información útil, pero no sin un coste.

El Demonio de Maxwell: Un Desafío Conceptual que Impulsó la Física

Este experimento mental de 1867 planteó una paradoja que desafiaba la segunda ley de la termodinámica. Su resolución, décadas después, llevó a una comprensión más profunda de la relación intrínseca entre información, entropía y energía, sentando bases para la termodinámica de la información.

El demonio de Maxwell ha sido un catalizador para la investigación en termodinámica de la información, el control cuántico y los límites fundamentales de lo que es posible en el universo. Es este espíritu de control preciso sobre el caos lo que el experimento de Caltech ha logrado, de una manera que recuerda sorprendentemente a la criatura imaginaria de Maxwell.

El Experimento de Caltech: Reviviendo al Demonio con Precisión Cuántica Asombrosa

El equipo dirigido por el físico Manuel Endres en Caltech ha logrado un avance que, por primera vez, traduce el concepto del demonio de Maxwell a una realidad experimental a escala atómica. Su técnica les permite un control sin precedentes sobre el movimiento térmico de átomos individuales, transformando lo que antes era un obstáculo en un recurso valioso para la información cuántica.

Trampas Ópticas y Enfriamiento Preciso:

El experimento se basa en la manipulación de átomos individuales atrapados con láseres.

-

Pinzas Ópticas (Optical Tweezers): Se utilizan haces de luz láser altamente enfocados para crear "trampas" que sujetan átomos individuales en el espacio, aislándolos de su entorno y permitiendo un control preciso.

-

Enfriamiento al Estado Fundamental: Los átomos son enfriados hasta dejarlos en lo que se conoce como su estado de movimiento fundamental. Este es el nivel más bajo de energía vibracional posible, donde el movimiento térmico aleatorio se reduce al mínimo cuántico. Lograr esto es una hazaña técnica en sí misma.

Manipulación del Movimiento Térmico: Convirtiendo el Ruido en Información:

Aquí es donde la analogía con el demonio de Maxwell se vuelve más evidente. El movimiento de los átomos, incluso en su estado fundamental, tiene una energía residual (movimiento de punto cero) y puede adquirir excitaciones térmicas (ruido). Lo que el equipo de Endres logró es una técnica que:

-

Convierte Excitaciones en Errores Detectables: Utilizan una técnica precisa que transforma las excitaciones térmicas no deseadas (el "ruido") en "errores localizados" dentro del sistema cuántico. Los autores lo llaman "conversiones de borrado", lo que es una clara referencia a la termodinámica de la información.

-

Corrección Activa de Errores: Una vez detectados estos "errores" (que provienen del movimiento térmico), el sistema los corrige activamente. Esto se logra mediante una combinación de mediciones precisas del movimiento de cada átomo y la aplicación de operaciones cuánticas específicas para restaurar el estado deseado.

"Esta técnica de enfriamiento recuerda al experimento mental de Maxwell, y se basa en la conversión de excitaciones en errores detectables y su posterior corrección activa", comentan los autores. Es decir, el sistema actúa como un "demonio" que mide el estado térmico (velocidad) de los átomos, y aplica una operación (abre o cierra la puerta, o en este caso, corrige el error) dependiendo del resultado, átomo por átomo, sin alterar los átomos que están en el estado deseado.

Integración con Estados Internos y Espín:

Lo más impactante es que esta manipulación del movimiento se combina con el control de los estados internos de los átomos (como su estado de espín o energía electrónica). Esto permite que el movimiento físico se convierta en un grado de libertad adicional para almacenar y procesar información cuántica. La detección y corrección se realiza sin alterar los átomos que ya están en el estado deseado, lo que mantiene la coherencia del sistema y evita que el proceso de medición destruya la información cuántica, un paso clave para la estabilidad de cualquier futuro computador cuántico funcional.

El éxito en este control sin precedentes del movimiento atómico individual, transformando el "ruido" en un recurso útil, es lo que ha hecho que el experimento de Caltech sea un hito significativo en la física cuántica experimental.

Convertir el Desorden en Herramienta Cuántica: La Ingeniería del Ruido Térmico

En el mundo de la física cuántica, el movimiento térmico de los átomos suele ser el enemigo número uno de la coherencia cuántica. Los computadores cuánticos y los simuladores requieren que las partículas (qubits) se mantengan en estados cuánticos puros y entrelazados durante el mayor tiempo posible. Cualquier interacción con el entorno, especialmente el movimiento térmico (que se traduce en choques aleatorios o variaciones energéticas), puede "descoherenciar" los qubits, haciendo que pierdan su información cuántica. Por eso, los experimentos cuánticos a menudo se realizan a temperaturas cercanas al cero absoluto.

Pero en el experimento de Caltech, la filosofía ha sido diferente. En lugar de simplemente minimizar el movimiento térmico como un "ruido" molesto, lo han aprovechado. Han desarrollado una técnica que convierte estas excitaciones térmicas en un tipo específico de información o "errores localizados" que pueden ser detectados y, crucialmente, corregidos activamente.

El "Ruido" como Fuente de Información:

Imagina que el movimiento térmico es como una agitación constante. En lugar de intentar detener toda la agitación (lo cual es imposible por la termodinámica y la mecánica cuántica), los científicos han encontrado una manera de que esa agitación se manifieste de una forma que les diga algo útil. Han diseñado un proceso que transforma esas "excitaciones térmicas" aleatorias en un "bit de información" que puede ser leído. Una vez que ese bit de información se ha leído, se puede aplicar una operación para "reiniciar" el átomo a su estado fundamental de movimiento, eliminando el "ruido" y manteniendo el sistema coherente.

Esto se asemeja a cómo el demonio de Maxwell usa la información sobre la velocidad de una partícula para actuar sobre ella. Aquí, el sistema mide el estado de movimiento térmico (el "ruido"), lo convierte en una señal detectable (el "error"), y luego actúa sobre el átomo para corregir ese "error" y enfriarlo al estado deseado, todo sin destruir la coherencia del sistema principal. Es una forma de "domar" el ruido térmico y convertirlo en una herramienta, en lugar de un problema.

Ampliando el Repertorio de Herramientas Cuánticas:

La capacidad de controlar y utilizar el movimiento térmico de esta manera amplía el repertorio de herramientas disponibles en computación y simulación cuántica.

-

Nuevos Qubits o Grados de Libertad: El movimiento térmico, que antes era una fuente de errores, ahora puede ser tratado como un grado de libertad adicional para codificar información cuántica (un "qubit" extra por átomo), aumentando la densidad de información por partícula.

-

Simulaciones Más Robustas: Permite diseñar simulaciones cuánticas más robustas que pueden manejar mejor el ruido térmico, o incluso utilizarlo de manera constructiva.

El Arte de la Coherencia: Combatir el Ruido Cuántico

En la computación cuántica, el "ruido" térmico es el enemigo de la coherencia cuántica. Este experimento de Caltech, al convertir el movimiento térmico en información útil y luego corregirlo, demuestra una forma ingeniosa de "domar" el caos inherente a la escala cuántica, abriendo nuevas vías para mantener la estabilidad de los qubits y avanzar en la construcción de computadoras cuánticas funcionales.

Este enfoque innovador de convertir el desorden en una herramienta es una demostración brillante de la creatividad en la física experimental, y tiene el potencial de ser un habilitador clave para el desarrollo de tecnologías cuánticas más estables y potentes.

¿Qué es Exactamente el Hiperentrelazamiento Cuántico? Un Doble Estado Conectado

El entrelazamiento cuántico es, quizás, el concepto más famoso y misterioso de la mecánica cuántica. Se refiere a la conexión profunda entre dos o más partículas, donde el estado de una partícula está intrínsecamente ligado al estado de otra, sin importar la distancia que las separe. La medición del estado de una partícula instantáneamente determina el estado de la otra, como si estuvieran comunicándose a través de un canal invisible. Esta "acción fantasmagórica a distancia", como la llamó Einstein, es la base de la computación y comunicación cuántica.

Más Allá del Entrelazamiento Simple:

El entrelazamiento simple ocurre cuando una única propiedad de dos partículas (por ejemplo, el espín de dos electrones o la polarización de dos fotones) está correlacionada. El hiperentrelazamiento, sin embargo, lleva este concepto un paso más allá. Se refiere a un estado cuántico en el que dos o más propiedades independientes de las mismas partículas (o de diferentes partículas) están entrelazadas simultáneamente. Es un entrelazamiento "doble" o "múltiple".

En el experimento de Caltech, el hito fue lograr el hiperentrelazamiento entre:

-

El Estado Interno del Átomo: Esto puede referirse a su estado electrónico (niveles de energía) o a su estado de espín (una propiedad cuántica intrínseca).

-

El Movimiento Físico del Átomo: Su oscilación o vibración en el espacio dentro de la trampa óptica.

Es decir, el equipo logró crear un estado donde la energía interna de un átomo no solo está entrelazada con la energía interna de otro átomo, sino que el movimiento de un átomo también está entrelazado con su propio estado interno, y con el movimiento y estado interno del otro átomo. Esto crea una correlación mucho más rica y compleja.

Logro Sin Precedentes en Partículas Masivas:

El hiperentrelazamiento no es un concepto totalmente nuevo. Anteriormente, ya se había observado en fotones. Los fotones son partículas sin masa y son relativamente fáciles de entrelazar en múltiples propiedades (polarización, orbital, momento angular). Sin embargo, lograr el hiperentrelazamiento en partículas masivas como átomos neutros es una hazaña técnica y conceptual mucho más difícil. Las partículas masivas interactúan más fuertemente con su entorno y son mucho más susceptibles a la descoherencia (la pérdida de su estado cuántico frágil).

-

Dificultad del Control: Controlar simultáneamente el estado interno y el movimiento físico de átomos individuales con la precisión necesaria para el hiperentrelazamiento es un desafío técnico inmenso.

-

Sensibilidad al Ruido: Los átomos son más sensibles al ruido térmico y a las interacciones con el entorno, lo que hace que mantener la coherencia cuántica sea más difícil.

El éxito en este experimento demuestra un nivel de control sobre los átomos individuales que abre nuevas vías para la manipulación cuántica y tiene profundas implicaciones para la computación cuántica.

Implicaciones para la Computación Cuántica:

El hiperentrelazamiento es un recurso valioso para la computación cuántica porque:

-

Mayor Densidad de Información (Qubits por Partícula): "Esto nos permite codificar más información cuántica por átomo". Un átomo puede contener dos qubits simultáneamente (uno en su estado interno, otro en su movimiento), lo que significa que se obtiene más entrelazamiento con menos recursos. Esto es crucial para escalar futuros ordenadores cuánticos, ya que cada qubit físico es difícil de crear y mantener.

-

Nuevas Vías de Entrelazamiento: Demuestra que se pueden entrelazar diferentes propiedades (internas y externas) de los átomos, abriendo nuevas posibilidades para diseñar algoritmos cuánticos y manipular información de formas más ricas.

El hiperentrelazamiento en partículas masivas es, por tanto, un avance técnico que tiene implicaciones directas en la viabilidad y la potencia de las futuras tecnologías cuánticas.

Una Nueva Herramienta para Computación y Simulación Cuántica: Más Allá del Truco de Laboratorio

El experimento de hiperentrelazamiento de Caltech no es un mero logro técnico o una curiosidad de laboratorio. Su utilidad va mucho más allá de lo conceptual, abriendo nuevas vías prácticas para el desarrollo de la computación y la simulación cuántica.

Lecturas Intermedias y Corrección de Errores:

Uno de los mayores desafíos en la computación cuántica es el problema de la descoherencia y los errores. Los qubits son frágiles y cualquier interacción con el entorno puede corromper su estado. Para construir ordenadores cuánticos funcionales, son esenciales los protocolos de corrección de errores cuánticos. Estos protocolos a menudo requieren "leer" el estado de los qubits durante la ejecución de un circuito cuántico para identificar errores, sin destruir el estado de los qubits que están realizando la computación principal.

-

La Fragilidad de los Qubits: Los estados cuánticos son extremadamente frágiles y se colapsan o "descoherencian" fácilmente.

-

Lecturas Intermedias no Destructivas: La técnica desarrollada por Caltech permite realizar lecturas intermedias de circuitos cuánticos sin alterar los átomos que están en el estado deseado. Esto es fundamental para implementar protocolos de corrección de errores cuánticos y para obtener información sobre el estado del sistema sin detener la computación.

La capacidad de medir sin destruir el estado cuántico es un paso crucial hacia la construcción de computadoras cuánticas tolerantes a fallos.

Simulaciones Cuánticas Más Complejas:

Los simuladores cuánticos son herramientas que utilizan sistemas cuánticos controlados para modelar otros sistemas cuánticos, lo que es inmensamente útil para la ciencia de materiales, la química y la física de partículas. Esta nueva técnica abre la posibilidad de realizar simulaciones más complejas:

-

Modelado de Sistemas Intratables Clásicamente: Permite modelar sistemas físicos que son imposibles de estudiar con métodos clásicos debido a su complejidad cuántica.

-

Teorías de Gauge en Redes: Los autores señalan que estos estados motacionales (de movimiento) podrían usarse para estudiar teorías de gauge en redes, que son fundamentales para comprender las interacciones entre partículas subatómicas.

-

Códigos de Corrección Cuántica Bosónicos: La técnica es prometedora para implementar códigos de corrección cuántica bosónicos como el código GKP (Gottesman-Kitaev-Preskill), que son cruciales para construir qubits lógicos más estables a partir de qubits físicos ruidosos.

Potencialmente Escalable y Robusto:

Un aspecto muy prometedor del trabajo de Caltech es que la técnica no necesita cambiar de especie atómica ni introducir complicaciones técnicas adicionales para escalar. "Basta con manipular la profundidad de los "tweezers" ópticos (pinzas de luz que sujetan cada átomo) para dirigir la información." Esto sugiere que el sistema es potencialmente más escalable y robusto que otras arquitecturas de qubit.

La capacidad de manipular y leer información cuántica a través del movimiento físico de los átomos, además de sus estados internos, añade una nueva dimensión a la computación cuántica, ofreciendo una herramienta flexible y potente para el desarrollo de nuevos algoritmos y la simulación de sistemas complejos.

Abriendo Nuevas Vías para Computadores Cuánticos

Este experimento no es un simple truco; es una demostración de capacidades fundamentales que son esenciales para construir computadores cuánticos más robustos. La habilidad de realizar lecturas intermedias sin destruir estados, de modelar sistemas complejos y el potencial de escalabilidad lo posicionan como un avance clave en la carrera por la computación cuántica.

Implicaciones y Futuras Aplicaciones: Más Allá de la Computación Cuántica

El control del movimiento de los átomos individuales y el logro del hiperentrelazamiento cuántico no solo tienen implicaciones profundas para la computación y simulación cuántica, sino que abren la puerta a un abanico de aplicaciones potenciales que podrían transformar diversos campos de la ciencia y la tecnología.

Memoria Cuántica Estable:

La duración de los estados cuánticos lograda en el experimento fue notable: el sistema mantuvo la coherencia cuántica de su movimiento durante unos 100 milisegundos, un tiempo considerable en escalas cuánticas. Esto se logró, en parte, gracias a un protocolo tipo eco, similar al que se usa en experimentos de resonancia magnética para evitar interferencias del entorno. Este nivel de control y la prolongación de la coherencia sugieren que estos sistemas podrían emplearse como memoria cuántica estable.

-

Qubits Estables: Si los estados de movimiento pueden mantener la coherencia durante periodos más largos, podrían servir como qubits estables para almacenar información en futuros computadores cuánticos.

-

Cómputos Paralelos: La capacidad de que cada átomo actúe como dos qubits simultáneos (uno en su oscilación, otro en su energía electrónica) podría permitir cómputos paralelos más densos en futuros procesadores cuánticos.

Medidas Ultraprecisas y Relojes Atómicos:

El control de precisión sobre los átomos individuales tiene implicaciones directas para la metrología, el campo de las mediciones de precisión:

-

Relojes Atómicos: Los relojes atómicos actuales ya son increíblemente precisos, pero el control mejorado sobre los átomos podría llevar a la próxima generación de relojes, con una precisión aún mayor para aplicaciones como la navegación por satélite o la sincronización de redes de comunicación.

-

Sensores Cuánticos: El control cuántico de átomos individuales es la base para desarrollar sensores ultraprecisos de campos magnéticos, gravitacionales o aceleraciones, con aplicaciones en medicina, geología y física fundamental.

Nuevas Formas de Comunicación Cuántica:

El entrelazamiento es el corazón de la comunicación cuántica y la criptografía. El hiperentrelazamiento podría expandir estas posibilidades:

-

Canales de Comunicación Más Densos: Si cada partícula puede codificar más información, se podrían establecer canales de comunicación cuántica más densos y eficientes.

-

Criptografía Cuántica: El entrelazamiento y la superposición son la base de la distribución de claves cuánticas, un método de criptografía inquebrantable. El control mejorado sobre los átomos podría reforzar aún más estas técnicas.

Exploración de Conceptos Sofisticados:

El trabajo prepara el terreno para investigar ideas aún más avanzadas en física cuántica:

-

Múltiples Grados de Libertad por Átomo: Ir más allá de dos propiedades entrelazadas por átomo, explorando formas de codificar aún más información.

-

Protocolos de Interferencia Cuántica: Implementar protocolos más complejos que aprovechen la superposición y el entrelazamiento en sistemas grandes.

Tal como concluye el artículo original: "Los estados motionales podrían convertirse en un recurso poderoso para la tecnología cuántica, desde la computación hasta la simulación y las medidas de precisión". La simplicidad de manipular la profundidad de las "tweezers" ópticas para dirigir la información sugiere un camino potencialmente escalable para estas complejas aplicaciones.

Tablas Resumen: Conceptos Clave del Entrelazamiento Cuántico

Tabla 1: Tipos de Entrelazamiento Cuántico y Sus Propiedades

| Tipo de Entrelazamiento | Descripción | Propiedades Correlacionadas | Relevancia para Qubits |

|---|---|---|---|

| Simple | Conexión cuántica entre una única propiedad de dos o más partículas. | Espín, polarización, nivel de energía, posición. | Base para la mayoría de los qubits físicos y operaciones cuánticas. |

| Hiperentrelazamiento | Entrelazamiento simultáneo de dos o más propiedades independientes de las mismas partículas (o diferentes). | Ej: Espín y movimiento; polarización y momento orbital angular (en fotones). | Permite codificar más información por partícula, más qubits con menos recursos físicos, simulación compleja. |

Nota: El hiperentrelazamiento maximiza la capacidad de almacenamiento de información por cada unidad cuántica.

Tabla 2: Entrelazamiento en Partículas: Hito de Caltech (Fotones vs. Partículas Masivas)

| Tipo de Partícula | Ejemplo | Logros Anteriores de Entrelazamiento/Hiperentrelazamiento | Desafíos Clave / Relevancia del Hito de Caltech |

|---|---|---|---|

| Fotones (Partículas sin masa) |

Partículas de luz | Ampliamente utilizados para entrelazamiento simple y hiperentrelazamiento (polarización, momento angular, tiempo). | Fácil de entrelazar, pero difíciles de almacenar y reutilizar como qubits de memoria. |

| Partículas Masivas (Ej: Átomos Neutros) |

Átomos individuales de Rubidio, Iones atrapados | Entrelazamiento simple de espín o niveles de energía, pero el hiperentrelazamiento era un reto. | Difíciles de controlar sin descoherencia, sensibles al ruido térmico. Hito de Caltech: Primer hiperentrelazamiento en átomos masivos. Mayor potencial como qubits de memoria estables. |

Nota: Lograr el hiperentrelazamiento en partículas masivas es crucial para arquitecturas de computación cuántica basadas en átomos.

Conclusión: El Hito que Abre la Puerta al Futuro Cuántico de la Computación y Simulación

El experimento liderado por Manuel Endres en Caltech marca un hito fundamental en la física cuántica, demostrando un nivel de control sobre átomos individuales que solo podía concebirse en experimentos mentales. Al lograr el primer hiperentrelazamiento en partículas masivas, entrelazando simultáneamente el movimiento y el estado interno de átomos, los científicos han dado un paso monumental hacia la construcción de computadoras cuánticas más potentes y estables.

Este logro no solo es una proeza técnica que "revive" al Demonio de Maxwell al convertir el caos del movimiento térmico en información útil y corregible, sino que también desbloquea nuevas vías para el desarrollo de la tecnología cuántica. La capacidad de codificar más información por átomo (más qubits por recurso físico) y la posibilidad de realizar lecturas intermedias no destructivas en circuitos cuánticos son avances cruciales para la corrección de errores y la escalabilidad de los futuros ordenadores cuánticos.

Más allá de la computación cuántica directa, esta técnica abre un abanico de aplicaciones potenciales en simulación cuántica de sistemas complejos, metrología de ultraprecisión (relojes atómicos y sensores avanzados) y nuevas formas de comunicación cuántica. La duración notable de la coherencia cuántica de los estados de movimiento sugiere un prometedor camino hacia el desarrollo de memorias cuánticas estables. El control sobre los átomos individuales, a través de pinzas ópticas y pulsos láser ajustados al nanosegundo, promete una flexibilidad y una escalabilidad sin precedentes para estas complejas aplicaciones.

El experimento de Caltech es un testimonio del ingenio humano y la perseverancia en la búsqueda de comprender y controlar la realidad en sus escalas más fundamentales. Nos recuerda que las fronteras de la física teórica y experimental están en constante expansión, y que las ideas más audaces, como la del Demonio de Maxwell, a menudo encuentran su sorprendente manifestación en el laboratorio. Este hito no solo profundiza nuestra comprensión del universo, sino que también acelera nuestra capacidad para aprovechar sus misteriosas reglas en beneficio de la tecnología y la humanidad.